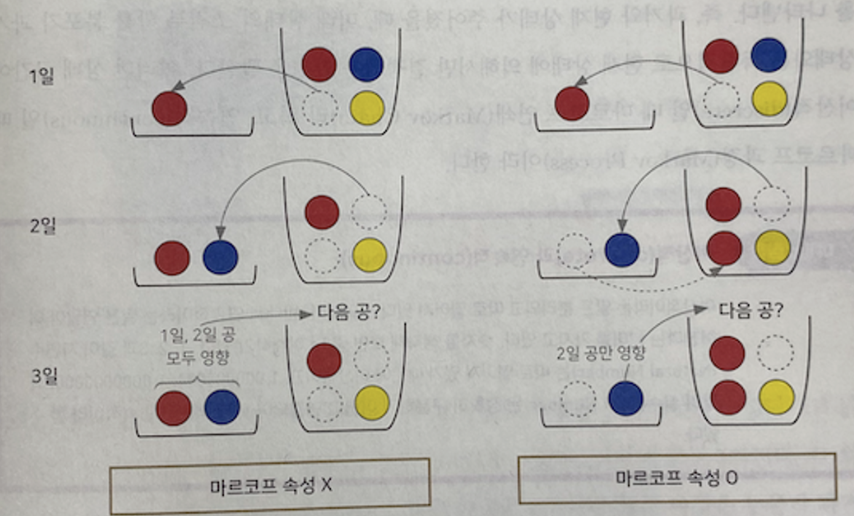

마르코프 속성

확률 과정의 특수한 형태로, 메모리를 가지지 않음

즉, 과거에 일어났던 모든 일은 무시하고 현재 상황만으로 미래를 예측하는 것

변수가 마르코프 속성을 지닌다 = 바로 이전 상황에만 영향을 받는다

- 1일차에 자루에서 공을 하나 뺀다.

- 2일차에 자루에서 공을 하나 뺀다.

- 2일차에 1일차에서 뺀 공을 다시 자루에 넣는다.

- 3일차에 자루에서 공을 뺀다.

과거의 일들을 무시하고 현재 상황만 고려하는 이유

→ 사건을 단순화하기 위해서 (과거까지 생각하면 데이터가 너무 많음)

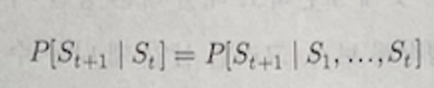

S(t+1)은 St만 영향 받는다.

마르코프 연쇄

마르코프 속성을 지닌 시스템의 시간에 따른 상태 변화

과거와 현재 상태가 주어졌을 때, 미래 상태의 조건부 확률 분포가

과거 상태와 독립적으로 현재 상태에 의해 결정되는 환경

이런 상태 공간이 이산적일 때, 마르코프 연쇄

연속적일 때, 마르코프 과정

이산적: 분리되고 따로 떨어져 있다는 의미, ex) 1, 2, 3..

연속적: 연달아 이어진다는 의미, ex) 1.00001, 1.0000002 ..마르코프 연쇄는 2가지 요소로 구성

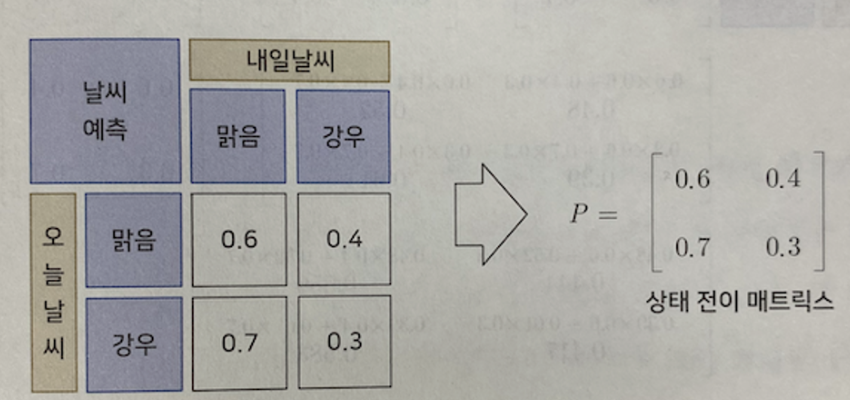

상태 집합(S)과 상태 전이 매트릭스(P)

상태전이 매트릭스는 각 상태별 확률을 행렬 형태로 모아놓은 것

날씨의 상태 집합(S)은 맑음, 강우 2가지

조건부 확률은 모두 4가지이다. 맑→맑, 맑→강, 강→맑, 강→강

오늘 날씨가 맑을 때, 3일 후 날씨 예측

마르코프 상태에서 과거는 고려하지 않으므로, 앞으로 일어날 조건부 확률만 곱하면 됨

그럼 오늘 날씨가 맑으면, 3일 후에 비가 올 확률이 더 높다는 결론이 도출됨

마르코프 연쇄는 마르코프 속성을 지닌 시스템의 시간에 따른 상태 변화를 나타내며

상태 집합과 상태 전이 매트릭스로 구성됨

위 예제는 조건부 확률을 매트릭스 형태로 표현

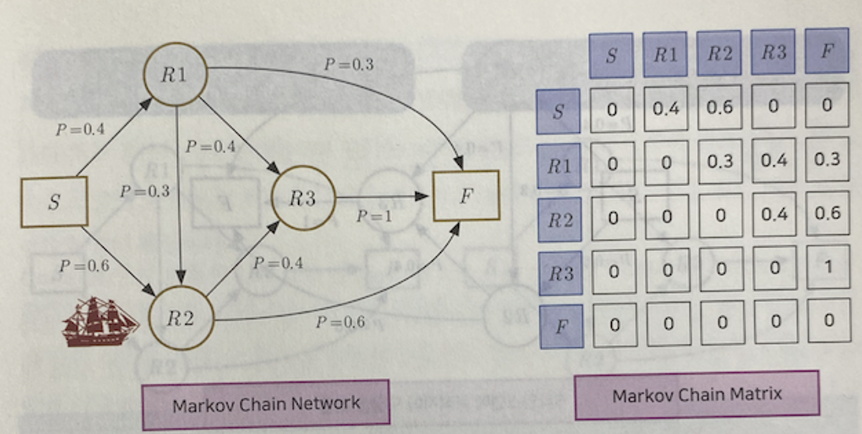

마르코프 연쇄는 두 가지의 형태로 표현

네트워크 방식 | 매트릭스 방식

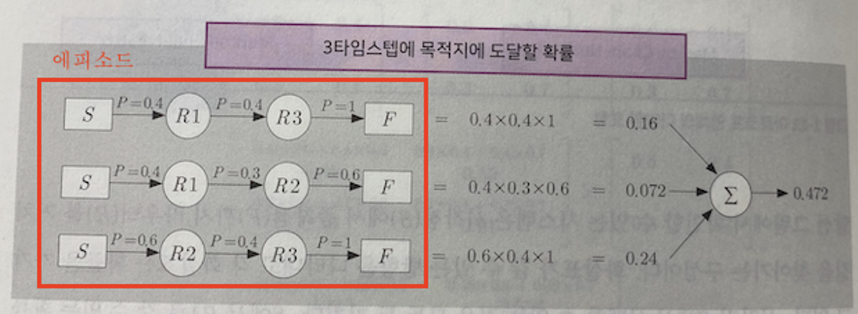

하나씩 이동하는 걸 타임 스텝이라 부름

에피소드 = 일련의 연속된 상태의 변화 = 위 예제는 3가지

'🎸 기타 > Reinforcement Learning' 카테고리의 다른 글

| [RL] MDP를 모를 때 밸류 평가하기 (1) | 2024.06.02 |

|---|---|

| [RL] MDP를 알 때 플래닝 (0) | 2024.05.23 |

| [RL] 벨만 방정식 (0) | 2024.05.20 |

| [RL] 마르코프 보상 과정 (MRP) | 마르코프 결정 과정 (MDP) (0) | 2024.04.30 |

| [RL] 강화학습이란 (0) | 2024.04.28 |